【論文サーベイ】Extracting visual concepts from Large Diffusion Models

443 Views

December 07, 23

スライド概要

Web Developer / Research on generative models and continual learning

関連スライド

各ページのテキスト

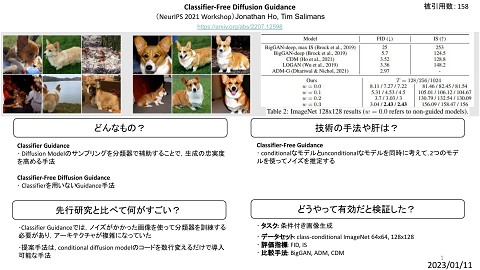

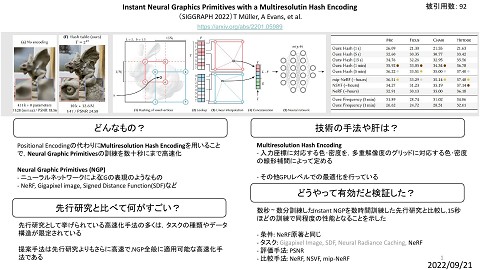

Extracting visual concepts from Large Diffusion Models An Image is Worth One Word: Personalizing Text-to-Image Generation using Textual Inversion R. Gal, Y. Alaluf, Y. Atzmon, O. patashnik, A. H. Bermano, G. Chechik, D. Cohen-Or [ICLR’23] DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation N. Ruiz, Y. Li, V. Jampani, Y. Pritch, M. Rubinstein, K. Aberman [CVPR’23] Multiresolution Textual Inversion G. Daras, A. G. Dimakis [NeurIPS’22 workshop] Encoder-based Domain Tuning for Fast Personalization of Text-to-Image Models R. Gal, M. Arar, Y. Atzmon, A. H. Bermano, G. Chechik, D. Cohen-Or [arxiv’23] 1

An Image is Worth One Word: Personalizing Text-to-Image Generation using Textual Inversion R. Gal, Y. Alaluf, Y. Atzmon, O. patashnik, A. H. Bermano, G. Chechik, D. Cohen-Or [ICLR’23] Keywords: Textual Inversion - 4~5枚の画像からコンセプト を抽出 をプロンプトに組み込んで画像生成が可能 2

アーキテクチャ Stable DiffusionのベースでもあるLDM [R. Rombach] を使用 textを でエンコードしてネットワークに入力する https://openaccess.thecvf.com/content/CVPR2022/html/Rombach_HighResolution_Image_Synthesis_With_Latent_Diffusion_Models_CVPR_2022_paper.html 3

手法 コンセプトを とおいて埋め込み表現 モデルを固定して に変換する で最適化 (この式自体はLDMの目的関数) ↳ のこと 4

結果 : コンセプト抽出 5

結果 : スタイル抽出 限界 : コンセプト画像が3 ~ 5枚必要 6

DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation N. Ruiz, Y. Li, V. Jampani, Y. Pritch, M. Rubinstein, K. Aberman [CVPR’23] - Text-to-Imageモデルのtext encoderを ファインチューニングすることでパーソナライズする手法 7

手法 プロンプト プロンプトを の形で与える クラスを表す名詞 Textual Inversionでは存在しないtokenにコンセプトを割り当てていたが, 提案手法ではText Encoderの辞書の中からrare-tokenを探索して使う rare-tokenにはLanguage ModelとDiffusion Modelのweak priorがあるので, 最適化が上手くいきやすい 8

手法 rare-tokenの抽出 : tokenizer : decoded text tokenをランダムにサンプリング tokenはT5-XXL tokenizerの { 5000, …, 10000} の範囲からサンプリング de-tokenizerに入れると3文字程度のUnicode charachterに対応する 論文中では 予め3文字程度のUnicode characterを用意しておいて使っても問題ない 9

手法 ファインチューニング reconstruction loss textからinput imagesを生成できるか class-specific prior preservation loss の導入による影響が無いか に対応 10

結果 input imagesから花瓶を 取り出せている 一般的なPCでも実験できそう 11

Multiresolution Textual Inversion G. Daras, A. G. Dimakis [NeurIPS’22 workshop] - コンセプトをどれだけ抽出するかを調整可能 - 3種類のサンプリング手法を提案 12

手法 textual inversion multiresolution textual inversion - テキスト埋め込みを - さらに,埋め込みをDiffusionの時間依存の形に変形 - に分解する を最適化する 13

モチベーション なぜ上手く行くのか ノイズ 少 多 ノイズの量が少ないとき text conditionは画像の細かい情報 (テクスチャ,毛並みなど) に働く ノイズの量が多いとき text conditionは画像の大域的な情報 (物体のクラスなど) に働く を選ぶことでtext conditionをコントロールできる 14

サンプリング手法 1. Fixed Resolution Sampling 全ての時刻で を使う 2. Semi Resolution-Dependent Sampling よりも大きい時刻で を使い それ以外のときはunconditional 3. Fully Resolution-Dependent Sampling よりも大きい時刻で それ以外のときは を使い

Encoder-based Domain Tuning for Fast Personalization of Text-to-Image Models R. Gal, M. Arar, Y. Atzmon, A. H. Bermano, G. Chechik, D. Cohen-Or [arxiv’23] 1枚の画像から1分程度でコンセプトを抽出 (from stable diffusion) 長いので次回紹介します 16

まとめ - Textual Inversion系の手法は入力画像を Diffusionの潜在変数ではなく解釈可能な text表現 に変換できる - SDEdit系の手法よりも生成の自由度が高そう - 当たり前ではあるがtext encoderをfine-tuningした方が性能は良い - 計算コストはそこまで大きく無さそう 17